Voilà très longtemps que je n’ai pas fait un billet sur les dimensions économiques que l’on peut relever dans les œuvres cinématographiques, parfois présentes de manière explicite, mais le plus souvent de manière totalement inconsciente dans l'esprit des scénaristes, seul mon esprit tordu ayant sans doute l'idée de les mettre en lumière...

[Certains lecteurs pensent alors fortement que c'est surtout du au fait qu'il n'y a que moi que cela intéresse ! Mais alors, quel paradoxe, car, lecteur, si tu en es arrivé à ce point, c'est que tu me lis et donc que tu es intéressé !]

J’ai revu récemment un des chefs d’œuvre du cinéma fantastique, "la mouche",, dans la version réalisée par David Cronenberg avec Jeff Goldblum, remake d'un classique des années 50 tout aussi bon, et un certain nombre de considérations économiques évoquées dans le film m’ont amusées. C'est l'objet de ce billet.

L’histoire est assez simple à résumer en quelques mots : un inventeur génial, physicien de son état, met au point un système permettant de téléporter d’abord de la matière inerte, puis, butant sur le problème de la téléportation des êtres vivants, trouve la solution, l’expérimente sur lui-même, ce qui causera sa fin. Au début du film, le scientifique dialogue avec la journaliste scientifique incarnée par Geena Davis et lui déclare la chose suivante pour la persuader d’écrire un livre qui relate sa découverte :

« Ce sera un livre sur l’invention qui a mis fin à tous les concepts sur les transports, les limites du temps et de l’espace ».

C’est là où j’ai bisqué.

En fait, cette idée renvoie au bon sens que nous avons tous et qui consiste à considérer que le problème du transport de biens ou de personnes est avant tout un problème de distance. Si la distance était abolie, au moyen d’un dispositif comme la téléportation, alors plus de problème de transport et un coût du transport nul ou quasi insignifiant.

En fait, cette idée renvoie au bon sens que nous avons tous et qui consiste à considérer que le problème du transport de biens ou de personnes est avant tout un problème de distance. Si la distance était abolie, au moyen d’un dispositif comme la téléportation, alors plus de problème de transport et un coût du transport nul ou quasi insignifiant.

Cela sonnerait-il le glas d’une discipline qui m’est chère, l’économie des transports, réduite à figurer au panthéon de l’histoire de la pensée, dans les oubliettes poussiéreuses réservées aux idées qui n’ont plus aucun intérêt, à l’instar par exemple de la théorie de la valeur marxiste ou de l’écrasante majorité des ouvrages de Bernard Henry-Levy ?

Précisément, rien n’est moins faux si on regarde la manière dont le problème du transport, notamment de personnes, est abordée dans la théorie économique moderne.

Les choses peuvent être comprises de manière intuitive : le problème du transport n’est pas seulement un problème de distance consistant à aller d’un point A à un point B, c’est aussi un problème de capacité de l’infrastructure qui permet de véhiculer choses ou êtres. Ce problème de capacité n’est pas du tout vu par le film, qui a d’autres chats, ou plutôt mouches, à fouetter et là n’est pas son propos essentiel.

Toutefois, ceci est un point central. Tirons le fil lié à la découverte révolutionnaire de Brundle, l’inventeur malheureux de la téléportation incarné par Goldblum. Imaginons que son dispositif devienne parfaitement fiable, et se généralise au point de rendre obsolètes toutes les infrastructures de transport, terrestres, maritimes, aériennes, etc. Le système de Brundle implique l’accès d’une personne à un télépod localisé en A, le transfert de cette personne vers un autre télépod localisé en B. Le point crucial est qu’il n’est possible de téléporter qu’un objet ou être vivant à la fois, c’est d’ailleurs la source de la malédiction de notre génial inventeur, la procédure durant quelques secondes, et le temps de transport total n’étant pas lié à la distance entre A et B, puisqu’il s’agit précisément de téléportation.

Il n’en reste pas moins que le système implique un goulot d’étranglement. Difficile d’envisager de construire autant de télépods (ceux-ci sont coûteux d’un simple point de vue économique) que de personnes souhaitant se déplacer, et, par conséquent, le système a une limite de capacité. Par exemple, cette limite pourrait être par exemple, de 60 déplacements par heure par télépod, en supposant le temps d’entrée et de sortie total égal à une minute.

Or, qui dit limite de capacité dit congestion potentielle, i.e. la possibilité d’avoir des coûts de transport non liés à la distance qui croissent en fonction de la demande de déplacement à un moment donné et en fonction du stock des déplacements restant à écouler au moment où je me présente devant le télépod. En effet, la congestion est un phénomène dynamique, qui implique un mécanisme de file d’attente, et par conséquent le temps de transport au moment m (ou le coût si je suppose négligeables les coûts financiers du déplacement dans un premier temps) croît en raison du total des déplacements restant à écouler, produit de la demande de déplacements pour les moments m-1, m-2, etc, précédents ainsi que de la demande instantanée en m. Le problème va être précisément qu’il n’est possible de transférer qu’une personne par minute…

Cette manière de concevoir le problème des déplacements de personnes et la formation de la congestion de manière dynamique a été proposée par William Vickrey en 1969 et formalisée par Richard Arnott, André de Palma et Robin Lindsey à la fin des années 80 dans ce qu’on appelle désormais les modèles de goulot d’étranglement (« bottleneck models »). Il faut bien dire que ces modèles, qui s'inspirent de la physique et de la recherche opérationnelle, ont constitué une véritable révolution dans le domaine de l’économie urbaine et de l’économie des transports.

Initialement, ces modèles cherchent à expliquer la formation de la congestion dans le cadre des déplacements quotidiens domicile travail en milieu urbain, en particulier les phénomènes de pointe du matin et du soir. Dans la configuration théorique la plus simple, tout le monde veut arriver au même endroit en même temps, on suppose des automobilistes homogènes, tous localisés au même endroit, et devant passer par le même itinéraire pour arriver par exemple dans le centre ville où sont localisés tous les emplois. Cet itinéraire a une certaine capacité d’écoulement par période de temps, par exemple 100 véhicules par minute. Les automobilistes doivent choisir simplement à quel moment partir de leur domicile sachant qu’ils doivent arriver à un moment précis, le même pour tous, et que leur coût de transport est constitué que du temps qu’ils passeront dans le goulot d’étranglement mais aussi du coût d’opportunité du temps lié au fait qu’ils peuvent arriver en avance ou en retard sur leur lieu de travail. Il y a donc un réel arbitrage à faire pour l’usager : soit je pars très tôt, je passe facilement le goulot car il n’y a pas grand monde, mais j’arrive en avance. Soit je pars très tard, au moment où il y a plus de monde, je subis le temps perdu dans le bouchon, et je risque en plus d’arriver en retard.

Initialement, ces modèles cherchent à expliquer la formation de la congestion dans le cadre des déplacements quotidiens domicile travail en milieu urbain, en particulier les phénomènes de pointe du matin et du soir. Dans la configuration théorique la plus simple, tout le monde veut arriver au même endroit en même temps, on suppose des automobilistes homogènes, tous localisés au même endroit, et devant passer par le même itinéraire pour arriver par exemple dans le centre ville où sont localisés tous les emplois. Cet itinéraire a une certaine capacité d’écoulement par période de temps, par exemple 100 véhicules par minute. Les automobilistes doivent choisir simplement à quel moment partir de leur domicile sachant qu’ils doivent arriver à un moment précis, le même pour tous, et que leur coût de transport est constitué que du temps qu’ils passeront dans le goulot d’étranglement mais aussi du coût d’opportunité du temps lié au fait qu’ils peuvent arriver en avance ou en retard sur leur lieu de travail. Il y a donc un réel arbitrage à faire pour l’usager : soit je pars très tôt, je passe facilement le goulot car il n’y a pas grand monde, mais j’arrive en avance. Soit je pars très tard, au moment où il y a plus de monde, je subis le temps perdu dans le bouchon, et je risque en plus d’arriver en retard.

La congestion se forme bien de manière dynamique : tant que la demande instantanée est inférieure ou égale à la capacité du goulot, le temps d’attente (ou de passage du goulot) est nul. Toutefois, dès que la demande instantanée devient supérieure à la capacité, la congestion commence à se former et les véhicules s’accumulent dans une file d’attente, et il devient de plus en plus long d’arriver à passer le goulot. Puis, le nombre des départs instantané baisse, et la congestion finit par se résorber. La règle à l’intérieur du goulot est bien sûr premier arrivé –premier servi.

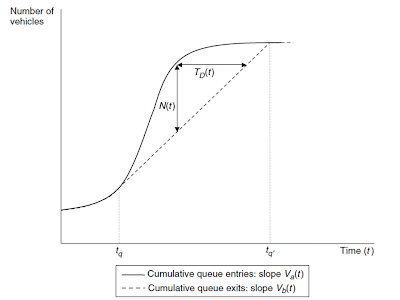

Le graphique ci-dessous, tiré de l’excellent livre de Ken Small et Eric Verhoef sur l’économie des transports urbains, illustre le modèle et la formation de la congestion :

Source : Small and Verhoef (2007), The Economics of Urban Transportation, Routledge.

Sur ce graphique, la valeur de N(t) représente l'écart entre la capacité cumulée au cours du temps (la droite en pointillés) et la demande cumulée à partir du moment où le nombre de départs devient supérieur à la capacité d'écoulement de la route (la courbe en traits pleins). La valeur horizontale T(t) correspond au temps passé dans le goulot pour un usager partant en t.

Il est même possible de simplifier encore le modèle, en supposant qu’un véhicule qui accède au goulot passe immédiatement si la capacité en t reste supérieure au stock de demande à écouler en t, puisque ce n’est pas un élément important en fait.

Il y a quelques années (désolé, je vais encore parler de moi comme dans le dernier billet), j’ai réalisé avec quelques collègues une série d’études expérimentales sur ce modèle (une référence ici), simplifié certes à outrance dans un cadre d’expérience de laboratoire, mais dont les résultats furent assez édifiants. Même avec un petit nombre de joueurs dans ce jeu de goulot d’étranglement, on observe la congestion de manière systématique, ce qui signifie que les participants n’arrivent pas à se coordonner suffisamment bien pour résoudre le problème de congestion, par exemple, le joueur 1 partant à l’heure 1, le joueur 2à l’heure 2, etc, ce qui minimiserait le coût total de transport, et l’efficacité serait de 100%. Dans nos expériences, le taux moyen d’efficacité tourne autour de 60%, ce qui est lié à la congestion. Par ailleurs les résultats observés en laboratoire sont assez proches des prédictions théoriques issues du modèle de goulot d’étranglement.

Il y a quelques années (désolé, je vais encore parler de moi comme dans le dernier billet), j’ai réalisé avec quelques collègues une série d’études expérimentales sur ce modèle (une référence ici), simplifié certes à outrance dans un cadre d’expérience de laboratoire, mais dont les résultats furent assez édifiants. Même avec un petit nombre de joueurs dans ce jeu de goulot d’étranglement, on observe la congestion de manière systématique, ce qui signifie que les participants n’arrivent pas à se coordonner suffisamment bien pour résoudre le problème de congestion, par exemple, le joueur 1 partant à l’heure 1, le joueur 2à l’heure 2, etc, ce qui minimiserait le coût total de transport, et l’efficacité serait de 100%. Dans nos expériences, le taux moyen d’efficacité tourne autour de 60%, ce qui est lié à la congestion. Par ailleurs les résultats observés en laboratoire sont assez proches des prédictions théoriques issues du modèle de goulot d’étranglement.

Plus récemment, l’American Economic Review a publié une étude expérimentale de Daniel, Gishes et Rapoport en 2009 sur une version plus sophistiquée de ce modèle de goulot, basée sur l’idée de bottlenecks qui s’emboitent dans un grand bottleneck (pour parler simplement, deux petites routes qui se connectent sur une grande route). Les auteurs testent l’impact d’une augmentation de la capacité d’une petite route en amont, toutes choses égales par ailleurs, sur les coûts de transport. Ils observent en laboratoire une forme de paradoxe de Braess (phénomène dont j’avais parlé ici ), qui fait que l’augmentation de la capacité débouche de manière contre-intuitive sur une augmentation des coûts totaux des déplacements.

Pour en revenir au film de Cronenberg, et pour faire le lien avec ce qui vient d’être dit, même avec la téléportation généralisée, il n’est pas sûr que l’augmentation de la capacité en télépods permette de résoudre définitivement le problème des coûts de déplacement si un phénomène du type Braess se produit (pour qu’il se produise, il suffit que l’augmentation de capacité ne soit pas trop forte). Comme quoi une innovation technologique, même révolutionnaire, ne sonne pas la fin de nos réflexions dans le domaine de l’économie des transports, et qu’au contraire, elle les stimule sans doute.

J’en suis arrivé à la conclusion que la projection du film la Mouche serait une magnifique introduction à un cours moderne d’économie des transports, en supposant toutefois que la plupart des étudiants n’aient pas rendu leur déjeuner ou leur goûter à l’issue de la projection - le film est assez gore par moments quand même - , faute de quoi, même avec du talent, il sera difficile de leur demander un effort intellectuel...